Inhalt

Als Lehrer:in oder Erzieher:in nutzt du wahrscheinlich bereits KI-Tools wie ChatGPT, Claude oder Gemini für deine Unterrichtsvorbereitung. Doch hast du schon einmal erlebt, dass eine KI dir mit großer Selbstsicherheit völlig falsche Informationen präsentiert hat? Dieses Phänomen nennt man KI Halluzinationen – und es ist eines der größten Risiken beim Einsatz künstlicher Intelligenz im Bildungsbereich.

In diesem umfassenden Leitfaden erfährst du, was KI Halluzinationen sind, warum sie entstehen und vor allem: wie du sie erkennst und vermeidest. Denn nur wer die Mechanismen versteht, kann KI verantwortungsvoll im Unterricht einsetzen.

Was sind KI Halluzinationen? Definition und Beispiele

KI Halluzinationen sind ein Phänomen, bei dem große Sprachmodelle (Large Language Models, LLMs) Informationen generieren, die faktisch falsch, unsinnig oder frei erfunden sind – diese aber mit absoluter Überzeugung präsentieren. Der Begriff mag paradox klingen, schließlich assoziieren wir Halluzinationen normalerweise mit menschlichen Gehirnen. Doch die Metapher trifft den Kern: Die KI „sieht“ Muster oder Zusammenhänge, die nicht existieren, und produziert daraus scheinbar plausible, aber falsche Ausgaben.

Im Gegensatz zu einem Taschenrechner, der deterministisch arbeitet und immer das gleiche korrekte Ergebnis liefert, funktionieren Sprachmodelle stochastisch. Sie berechnen Wahrscheinlichkeiten für das nächste Wort in einer Sequenz – und können dabei grandios danebenliegen.

Konkrete Beispiele für KI Halluzinationen im Bildungskontext

Stell dir vor, du fragst ChatGPT nach den Ursachen des Ersten Weltkriegs für deine 9. Klasse. Die KI antwortet eloquent und detailliert – nennt aber fälschlicherweise den „Vertrag von Paris 1913“ als Auslöser. Dieser Vertrag existiert nicht, klingt aber plausibel. Oder du bittest um Literaturempfehlungen zu einem speziellen Thema, und die KI erfindet Buchtitel mit Autor:innen, ISBN-Nummern und Verlagen – alles komplett frei erfunden, aber perfekt formatiert.

Ein besonders problematisches Beispiel aus der Praxis: Ein Anwalt nutzte ChatGPT für eine Recherche und reichte ein Schreiben ein, das auf sechs komplett erfundenen Gerichtsurteilen basierte. Die KI hatte die Urteile inklusive Aktenzeichen und Zusammenfassungen halluziniert. In der Schule könnte ein:e Schüler:in ähnlich auf KI Halluzinationen hereinfallen und fehlerhafte Informationen in Referaten oder Hausarbeiten verwenden.

Aktuelle Studien zeigen alarmierende Zahlen: ChatGPT liegt bei etwa 40 Prozent der Quellenangaben falsch, Gemini sogar bei 80 Prozent der Referenzen. Nur Claude schneidet mit einer Halluzinationsrate von 17 Prozent deutlich besser ab. Das bedeutet: KI Halluzinationen sind kein seltenes Phänomen, sondern ein systematisches Problem.

Warum entstehen KI Halluzinationen? Die Ursachen verstehen

Um KI Halluzinationen effektiv vermeiden zu können, musst du verstehen, warum sie überhaupt entstehen. Die Gründe sind vielfältig und liegen in der Funktionsweise der Modelle selbst:

1. Unzureichende oder fehlerhafte Trainingsdaten

KI-Modelle lernen aus riesigen Datenmengen – oft Milliarden von Texten aus dem Internet. Wenn diese Trainingsdaten lückenhaft, veraltet oder falsch sind, reproduziert die KI diese Fehler. Besonders problematisch: Wenn zu einem Nischenthema nur wenige oder gar keine Informationen vorliegen, erfindet die KI plausibel klingende Antworten, anstatt ihre Unwissenheit zuzugeben.

Ein Beispiel: Wenn du nach touristischen Attraktionen in einer kleinen, unbekannten Stadt fragst, halluziniert die KI oft Sehenswürdigkeiten, die nicht existieren – einfach weil sie zu wenig Daten über diesen Ort hat.

2. Bias und Verzerrungen in den Daten

Wenn Trainingsdaten einseitig sind, zeigt sich das in den Ergebnissen. Ein KI-Modell, das überwiegend mit Texten über männliche Ärzte trainiert wurde, könnte fälschlicherweise behaupten, alle Ärzte seien männlich. Auch nutzergenerierte Inhalte aus sozialen Medien oder Foren können Meinungen als Fakten präsentieren und so zu KI Halluzinationen führen.

3. Fehlerhafte Schlussfolgerungen und logische Lücken

KI-Modelle haben kein Verständnis für Kausalität oder logische Zusammenhänge. Sie können zwei korrekte Fakten falsch kombinieren. Ein klassisches Beispiel:

- Fakt 1: Albert Einstein erhielt den Nobelpreis für Physik

- Fakt 2: Albert Einstein entwickelte die Relativitätstheorie

- Falsche KI-Schlussfolgerung: Einstein erhielt den Nobelpreis für die Relativitätstheorie

Tatsächlich erhielt er den Preis für seine Erklärung des photoelektrischen Effekts – ein typischer Fall von KI Halluzinationen durch Fehlschlüsse.

4. Keine Kenntnis eigener Wissensgrenzen

Im Gegensatz zu Menschen wissen KI-Systeme nicht, was sie nicht wissen. Sie haben kein Bewusstsein für Unsicherheit. Während ein:e Lehrer:in sagen würde „Das weiß ich nicht genau, ich recherchiere das“, antwortet die KI mit derselben Selbstsicherheit auf Fragen, zu denen sie keine verlässlichen Daten hat – und halluziniert die Antwort.

5. Falsche Anreizsysteme beim Training

Eine bahnbrechende Erkenntnis von OpenAI: KI Halluzinationen werden durch die Art verstärkt, wie Modelle trainiert und bewertet werden. Bei Standard-Tests werden Modelle dafür belohnt, dass sie raten, anstatt zuzugeben, dass sie etwas nicht wissen. Ähnlich wie bei einem Multiple-Choice-Test: Eine geratene Antwort hat eine Chance, richtig zu sein – Enthaltung bringt garantiert null Punkte.

Daher lernen KI-Modelle, im Zweifel lieber eine Antwort zu erfinden, als keine zu geben. Das ist der Kern des Problems der KI Halluzinationen.

Arten von KI Halluzinationen: Von harmlosen Fehlern bis zu gefährlichen Fehlinformationen

Nicht alle KI Halluzinationen sind gleich. Sie lassen sich in verschiedene Kategorien einteilen:

Sachliche Fehler

Die KI gibt faktisch falsche Informationen, etwa historische Ungenauigkeiten, falsche Jahreszahlen oder wissenschaftliche Unwahrheiten. Beispiel: „Leonardo da Vinci malte die Mona Lisa im Jahr 1815“ – rund 300 Jahre zu spät.

Fabrizierte Inhalte

Die KI erfindet komplette Geschichten, Quellen oder Referenzen, die niemals existiert haben. Besonders tückisch: Diese erfundenen Inhalte sind oft so detailliert (mit Seitenzahlen, Zitaten, ISBN), dass sie authentisch wirken.

Unsinnige Ausgaben

Manchmal produziert KI völlig absurde Antworten, die keiner Logik folgen. Googles Gemini antwortete auf die Frage nach Früchten, die auf „-um“ enden, mit „applum, bananum, strawberrum, tomatum“ – allesamt erfundene Wörter.

Mathematische Halluzinationen

Selbst bei einfachen Rechenaufgaben können KI Halluzinationen auftreten. Ältere Modelle scheiterten oft an Grundrechenarten, neuere haben Probleme mit komplexeren Aufgaben oder ungewöhnlichen Zahlen, die in den Trainingsdaten unterrepräsentiert sind.

Die Gefahren von KI Halluzinationen im Bildungsbereich

Für dich als Lehrkraft sind KI Halluzinationen besonders problematisch. Sie können:

- Fehlinformationen verbreiten: Schüler:innen übernehmen falsche Fakten in ihre Arbeiten

- Kritisches Denken untergraben: Wenn KI als „allwissend“ wahrgenommen wird, hinterfragen Lernende Informationen nicht mehr

- Vertrauen in Technologie missbrauchen: Die überzeugende Darstellung falscher Inhalte macht KI Halluzinationen besonders gefährlich

- Rechtliche Konsequenzen haben: Wie das Anwalts-Beispiel zeigt, können erfundene Informationen ernsthafte Folgen haben

- Soziale Ungerechtigkeiten verstärken: Wenn nur Lernende mit kritischer Medienkompetenz KI Halluzinationen erkennen, wächst die Bildungskluft

Eine aktuelle Studie der Europäischen Rundfunkunion zeigte: Populäre KI-Chatbots machen bei 40 Prozent der Antworten Fehler. Das ist keine Ausnahme, sondern die Regel – und macht deutlich, warum du als Pädagog:in KI Halluzinationen ernst nehmen musst.

So erkennst du KI Halluzinationen: Praktische Tipps für den Alltag

Die gute Nachricht: Es gibt konkrete Strategien, mit denen du KI Halluzinationen identifizieren kannst.

1. Kritisches Hinterfragen – immer

Behandle KI-Antworten nie als absolute Wahrheit. Frage dich:

- Klingt die Antwort zu perfekt oder zu detailliert?

- Werden konkrete Quellen genannt, die du überprüfen kannst?

- Macht die Antwort logisch Sinn?

- Passt die Information zu deinem Vorwissen?

2. Faktencheck mit verlässlichen Quellen

Überprüfe wichtige Informationen immer mit unabhängigen, vertrauenswürdigen Quellen. Nutze:

- Wissenschaftliche Datenbanken

- Offizielle Institutionen (z.B. Statistische Ämter, Regierungsseiten)

- Anerkannte Bildungsmedien

- Fachliteratur

Niemals solltest du KI-generierte Quellenangaben ungeprüft übernehmen.

3. Cross-Checking mit mehreren KI-Tools

Stelle die gleiche Frage an verschiedene KI-Modelle. Wenn ChatGPT, Claude und Gemini unterschiedliche Antworten geben, ist Vorsicht geboten. Übereinstimmungen sind ein gutes Zeichen – aber kein Beweis.

4. Konsistenzprüfungen durchführen

Stelle Folgefragen, die logisch aufeinander aufbauen. KI Halluzinationen zeigen sich oft durch Widersprüche. Beispiel:

- Frage 1: „Ist 3.821 eine Primzahl?“

- KI: „Nein, sie ist durch 53 und 72 teilbar.“

- Frage 2: „Was ist 53 mal 72?“

- KI: „3.816“

- Du erkennst: Die Antworten widersprechen sich – es liegt eine KI Halluzination vor.

5. Nach Unsicherheit fragen

Bitte die KI explizit, ihre Unsicherheit anzugeben: „Wie sicher bist du dir bei dieser Antwort? Gibt es Informationen, die fehlen könnten?“ Viele neuere Modelle können ihre Grenzen besser kommunizieren.

6. Spezifische Themen vorsichtig behandeln

Sei besonders skeptisch bei:

- Nischenthemen mit wenig verfügbaren Daten

- Aktuellen Ereignissen (Modelle haben ein Trainingsdaten-Cutoff)

- Regionalen Informationen zu kleinen Orten

- Spezialisierten Fachgebieten (Medizin, Recht, Wissenschaft)

Bei diesen Themen sind KI Halluzinationen besonders wahrscheinlich.

Wie du KI Halluzinationen vermeidest: Strategien für Lehrkräfte

Jetzt weißt du, wie du KI Halluzinationen erkennst. Aber noch wichtiger: Wie kannst du sie von vornherein verhindern?

1. Das richtige KI-Modell wählen

Nicht alle KI-Tools sind gleich anfällig für KI Halluzinationen. Wähle Modelle mit:

- Integrierter Web-Suche für aktuelle Informationen (z.B. ChatGPT mit Websuche, Perplexity, Gemini)

- Niedrigen Halluzinationsraten (Claude liegt bei nur 17 Prozent)

- Transparenten Quellenangaben, die du überprüfen kannst

Für faktentreue Aufgaben ist Claude die beste Wahl im Vergleich. Für kreative Aufgaben, bei denen exakte Fakten weniger wichtig sind, sind KI Halluzinationen weniger kritisch.

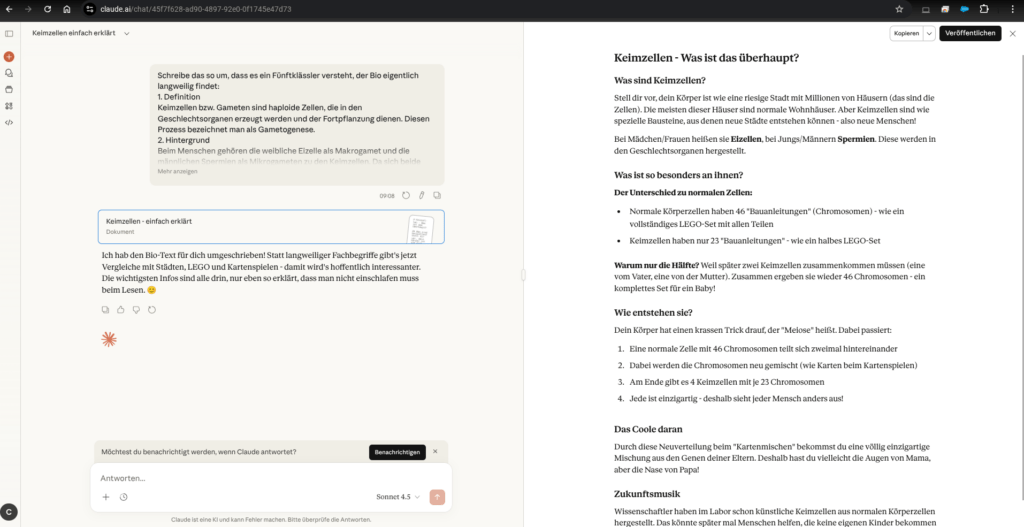

2. Prompt Engineering: Präzise Anfragen stellen

Die Qualität deiner Prompts beeinflusst direkt das Risiko von KI Halluzinationen. Befolge diese Regeln:

Sei spezifisch: Anstatt „Erkläre Photosynthese“ besser: „Erkläre die Lichtreaktion der Photosynthese für Schüler:innen der 9. Klasse, mit einem Fokus auf die Rolle von Chlorophyll. Nenne nur wissenschaftlich belegte Fakten.“

Fordere Quellenangaben: „Beantworte die Frage und gib für jede Aussage eine überprüfbare Quelle an.“

Setze Grenzen: „Wenn du dir unsicher bist oder die Informationen nicht kennst, sage das explizit, anstatt zu raten.“

Nutze Chain-of-Thought Prompting: „Erkläre Schritt für Schritt, wie du zu dieser Antwort kommst“ – das reduziert KI Halluzinationen um bis zu 20 Prozent.

Auf Lehrwert.com findest du einen umfassenden Leitfaden zu Prompt Engineering, der dir zeigt, wie du KI-Tools optimal nutzt und KI Halluzinationen minimierst.

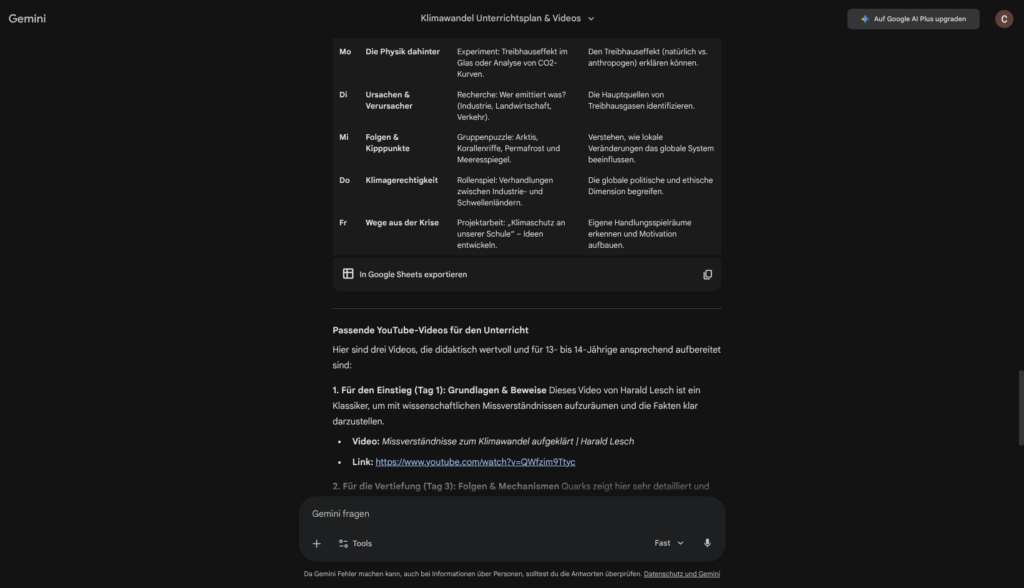

3. Retrieval-Augmented Generation (RAG) nutzen

RAG ist eine Technik, bei der die KI nicht nur auf ihr internes Wissen zurückgreift, sondern auf eine kuratierte Wissensbasis zugreifen kann. Du gibst der KI konkrete Dokumente, Lehrmaterialien oder Datenbanken, aus denen sie Informationen ziehen soll.

Beispiel: „Beantworte die Frage ausschließlich basierend auf diesem Lehrbuch [PDF hochladen]. Wenn die Antwort nicht im Text steht, sage das.“

Das reduziert KI Halluzinationen drastisch, weil die KI nicht mehr auf unsichere Muster aus den Trainingsdaten angewiesen ist.

4. Temperatur-Einstellungen anpassen

Viele KI-Tools erlauben es, die „Temperatur“ anzupassen – ein Parameter, der steuert, wie „kreativ“ oder „konservativ“ die Antworten sind. Eine niedrige Temperatur (z.B. 0.3) reduziert KI Halluzinationen, weil die KI weniger spekulativ antwortet.

Prompt-Beispiel: „Beantworte folgende Frage mit einer Temperatur von 0.5, um Halluzinationen zu vermeiden: Wann malte Leonardo da Vinci die Mona Lisa?“

5. Guardrails und Filter einsetzen

Technische Schutzmechanismen (Guardrails) können KI-Ausgaben in Echtzeit überwachen und problematische Antworten erkennen. Für den Schulalltag gibt es spezialisierte Tools wie fobizz, schulKI oder Kiwi, die bereits mit solchen Mechanismen arbeiten und DSGVO-konform sind.

Diese Tools sind speziell für den deutschen Bildungsmarkt entwickelt und minimieren das Risiko von KI Halluzinationen durch zusätzliche Prüfungsebenen.

6. Menschliche Überprüfung – immer

Die wichtigste Regel: Verlasse dich nie blind auf KI. Plane Zeit für die Nachbearbeitung ein (die 80/20-Regel: 80 % KI-generiert, 20 % menschliche Überprüfung). Du bist die Expertin bzw. der Experte – nutze dein pädagogisches Fachwissen, um KI Halluzinationen zu identifizieren und zu korrigieren.

KI Halluzinationen im Unterricht thematisieren

Eine der wichtigsten Aufgaben als Lehrkraft: Schüler:innen über KI Halluzinationen aufklären. Nur wer das Phänomen versteht, kann kritisch mit KI-generierten Inhalten umgehen.

Unterrichtsideen zu KI Halluzinationen

Experiment: Halluzinationen provozieren

Bitte Schüler:innen, bewusst nach Informationen zu fragen, die wahrscheinlich zu KI Halluzinationen führen (z.B. obskure historische Ereignisse, fiktive Personen). Analysiert gemeinsam, woran man die Fehler erkennt.

Quellencheck-Challenge

Gebt einer KI die Aufgabe, Literaturempfehlungen mit ISBN-Nummern zu generieren. Schüler:innen überprüfen, ob die Quellen wirklich existieren – ein praktisches Training im Faktencheck.

KI vs. Mensch: Wer halluziniert mehr?

Diskutiert, dass auch Menschen „halluzinieren“ (Fehlerinnerungen, Confirmation Bias). Was sind die Unterschiede? Wie gehen wir damit um?

Ethik-Diskussion

Wer trägt die Verantwortung, wenn ein:e Schüler:in durch KI Halluzinationen falsche Informationen verbreitet? Die KI? Der Anbieter? Die nutzende Person?

Diese Thematisierung fördert Medienkompetenz und kritisches Denken – zwei Schlüsselkompetenzen für die Zukunft.

Die Zukunft: Werden KI Halluzinationen jemals verschwinden?

Die schlechte Nachricht zuerst: KI Halluzinationen lassen sich niemals vollständig verhindern. Die stochastische Natur von Sprachmodellen macht Fehler unvermeidbar. Expert:innen sind sich einig: Selbst mit besseren Trainingsdaten und verfeinerten Algorithmen bleibt ein Restrisiko.

Die gute Nachricht: Es gibt Fortschritte. OpenAI, Anthropic und Google arbeiten intensiv daran, KI Halluzinationen zu reduzieren. Neue Ansätze umfassen:

- Reasoning-Modelle (wie OpenAI’s o3), die strukturierter „denken“ und Antworten in Zwischenschritten validieren

- Bessere Benchmarks, die Modelle nicht fürs Raten belohnen, sondern fürs Eingestehen von Unsicherheit

- Self-Consistency-Checks, bei denen die KI ihre eigenen Antworten mehrfach generiert und auf Widersprüche prüft

- Chain-of-Verification (CoVe), bei dem die KI Behauptungen systematisch verifiziert

Neuere Modelle wie Claude 4 Sonnet oder GPT-5 zeigen bereits deutlich niedrigere Halluzinationsraten als ihre Vorgänger. Die Entwicklung geht in die richtige Richtung – aber du musst weiterhin wachsam bleiben.

Datenschutz und KI Halluzinationen: Ein wichtiger Zusammenhang

Ein oft übersehener Aspekt: KI Halluzinationen können auch datenschutzrelevant sein. Wenn eine KI personenbezogene Daten halluziniert (z.B. falsche Informationen über Schüler:innen generiert), verstößt das möglicherweise gegen die DSGVO.

Daher: Gib niemals personenbezogene Daten von Schüler:innen in KI-Tools ein. Nutze anonymisierte Beispiele und achte auf DSGVO-konforme Tools. Mehr dazu erfährst du im Artikel DSGVO und AI Act im Klassenzimmer.

Deine nächsten Schritte: KI-Kompetenz systematisch aufbauen

Du siehst: Das Thema KI Halluzinationen ist komplex. Um KI-Tools verantwortungsvoll im Bildungsbereich einzusetzen, brauchst du fundierte KI-Kompetenz. Nur wer versteht, wie KI funktioniert, welche Limitationen es gibt und wie man die Tools optimal nutzt, kann KI Halluzinationen effektiv vermeiden.

Der KI-Kompetenz Kurs für Bildungsprofis bietet dir eine systematische Lernreise: von den Grundlagen künstlicher Intelligenz über rechtliche Rahmenbedingungen (DSGVO, AI Act) bis hin zu didaktischen Einsatzszenarien. Du lernst nicht nur Theorie, sondern erhältst praktische Strategien für deinen Schulalltag – inklusive professionellem Zertifikat.

Besonders relevant: Der Kurs behandelt ausführlich das Thema KI Halluzinationen, zeigt dir Techniken zur Erkennung und Vermeidung und gibt dir Werkzeuge an die Hand, um deine Schüler:innen zu kompetenten KI-Nutzer:innen zu machen. Perfekt für Lehrkräfte, die sich umfassend fortbilden möchten.

Weitere hilfreiche Ressourcen auf Lehrwert.com:

- KI-Projekte im Schulalltag: Von der Idee zur Umsetzung

- Die besten kostenlosen KI-Apps für Schule und Kita

- KI-Fortbildungen für Lehrer – Diese Angebote lohnen sich

FAQ: Häufig gestellte Fragen zu KI Halluzinationen

Was sind KI Halluzinationen einfach erklärt?

KI Halluzinationen sind falsche, unsinnige oder frei erfundene Informationen, die künstliche Intelligenz generiert, aber mit großer Überzeugung als Fakten präsentiert. Die KI „sieht“ Muster, die nicht existieren, und produziert daraus scheinbar plausible, aber falsche Ausgaben – ähnlich wie bei menschlichen Halluzinationen.

Warum halluzinieren KI-Modelle?

Die Hauptursachen für KI Halluzinationen sind: unzureichende oder fehlerhafte Trainingsdaten, Bias und Verzerrungen, fehlerhafte logische Schlussfolgerungen, keine Kenntnis eigener Wissensgrenzen und falsche Anreizsysteme beim Training. KI-Modelle funktionieren stochastisch (basierend auf Wahrscheinlichkeiten), nicht deterministisch wie ein Taschenrechner.

Welche KI halluziniert am wenigsten?

Im direkten Vergleich hat Claude mit nur 17 Prozent die niedrigste Halluzinationsrate, gefolgt von ChatGPT mit etwa 40 Prozent bei Quellenangaben. Gemini schneidet bei Referenzen mit 80 Prozent Fehlerquote schlechter ab, ist aber bei faktischen Aussagen innerhalb des Trainingsmaterials genau. Für faktentreue Aufgaben ist Claude die sicherste Wahl.

Sind KI Halluzinationen vermeidbar?

Nein, KI Halluzinationen lassen sich nicht vollständig vermeiden – sie sind ein inhärentes Problem der stochastischen Funktionsweise von Sprachmodellen. Expert:innen sind sich einig: Halluzinationen können minimiert, aber nie gänzlich beseitigt werden. Mit den richtigen Strategien (Prompt Engineering, RAG, Faktencheck) lässt sich das Risiko jedoch deutlich reduzieren.

Wie erkenne ich KI Halluzinationen?

Du erkennst KI Halluzinationen durch: kritisches Hinterfragen aller Antworten, Faktencheck mit unabhängigen Quellen, Cross-Checking mit mehreren KI-Tools, Konsistenzprüfungen durch Folgefragen, Nachfragen nach Unsicherheit und besondere Vorsicht bei Nischenthemen, aktuellen Ereignissen und spezialisierten Fachgebieten.

Welche Prompting-Techniken reduzieren KI Halluzinationen?

Effektive Techniken gegen KI Halluzinationen sind: Chain-of-Thought Prompting (schrittweises Erklären), niedrige Temperatur-Einstellungen (z.B. 0.3-0.5), explizite Quellenanforderungen, klare Grenzsetzung („Sage, wenn du unsicher bist“), spezifische und detaillierte Anfragen sowie Retrieval-Augmented Generation (RAG) mit kuratierter Wissensbasis.

Sind KI Halluzinationen gefährlich?

Ja, KI Halluzinationen können erhebliche Risiken bergen: Verbreitung von Fehlinformationen, Untergraben kritischen Denkens, rechtliche Konsequenzen (wie im Fall des Anwalts mit erfundenen Urteilen), Verstärkung sozialer Ungerechtigkeiten und Missbrauch von Vertrauen in Technologie. Im Bildungsbereich können sie zu falschen Lerninhalten und mangelnder Medienkompetenz führen.

Wie thematisiere ich KI Halluzinationen im Unterricht?

Sinnvolle Unterrichtsansätze: Experimente, um bewusst KI Halluzinationen zu provozieren, Quellencheck-Challenges mit ISBN-Nummern, Vergleich KI vs. menschliche „Halluzinationen“ (Fehlerinnerungen), Ethik-Diskussionen über Verantwortung und praktische Übungen zum Faktencheck. Das fördert Medienkompetenz und kritisches Denken.

Welche Tools helfen gegen KI Halluzinationen im Schulkontext?

Für den deutschen Bildungsmarkt entwickelte, DSGVO-konforme Tools wie fobizz, schulKI oder Kiwi haben integrierte Schutzmechanismen gegen KI Halluzinationen. Sie bieten Guardrails, Quellenvalidierung und sind speziell für den pädagogischen Einsatz konzipiert. Zusätzlich solltest du immer mit präzisen Prompts arbeiten und Ergebnisse überprüfen.

Werden KI Halluzinationen in Zukunft verschwinden?

Nein, KI Halluzinationen werden nie vollständig verschwinden, aber die Raten sinken kontinuierlich. Neue Entwicklungen wie Reasoning-Modelle (OpenAI o3), verbesserte Benchmarks, Self-Consistency-Checks und Chain-of-Verification (CoVe) reduzieren das Problem. Neuere Modelle wie Claude 4 oder GPT-5 zeigen bereits deutliche Verbesserungen gegenüber Vorgängern.

Was hat Datenschutz mit KI Halluzinationen zu tun?

KI Halluzinationen können datenschutzrelevant sein, wenn die KI personenbezogene Daten halluziniert (z.B. falsche Informationen über Schüler:innen). Das kann DSGVO-Verstöße darstellen. Daher: Gib niemals personenbezogene Daten in KI-Tools ein, nutze anonymisierte Beispiele und achte auf DSGVO-konforme Bildungstools. Mehr Infos im Artikel zu DSGVO und AI Act im Klassenzimmer.

Fazit: Mit Wissen gegen KI Halluzinationen

KI Halluzinationen sind keine Science-Fiction, sondern ein reales Problem, das du als Lehrkraft kennen und verstehen musst. Sie entstehen durch die Art, wie KI-Modelle funktionieren, und lassen sich nie vollständig vermeiden – aber mit den richtigen Strategien drastisch reduzieren.

Die wichtigsten Erkenntnisse:

- KI Halluzinationen sind systematisch, keine Ausnahme (40-80 % Fehlerquote je nach Modell)

- Sie entstehen durch unzureichende Daten, Bias, Fehlschlüsse und falsche Trainingsan reize

- Mit Prompt Engineering, RAG, Faktencheck und kritischem Denken kannst du KI Halluzinationen minimieren

- Die Thematisierung im Unterricht ist essentiell für Medienkompetenz

- Menschliche Überprüfung bleibt unverzichtbar

KI ist ein mächtiges Werkzeug für den Bildungsbereich – aber nur, wenn du es verantwortungsvoll einsetzt. KI Halluzinationen zu verstehen und zu vermeiden ist Teil dieser Verantwortung. Nutze die Tools in diesem Artikel, bilde dich kontinuierlich fort und bleibe kritisch. So schützt du dich und deine Schüler:innen vor den Risiken und nutzt gleichzeitig das enorme Potenzial der Technologie.

Die Zukunft der Bildung ist hybrid: Menschliche Expertise kombiniert mit KI-Unterstützung. Deine pädagogische Kompetenz, deine Empathie und dein kritisches Denken bleiben unersetzlich – gerade im Umgang mit KI Halluzinationen.

Transparenz: Manche Links sind Affiliate-Links. Für Dich entstehen keine Kosten, aber wir erhalten eine kleine Provision zur Unterstützung unserer Arbeit.